Apple lancia quattro nuovi modelli open source per perfezionare l’intelligenza artificiale del futuro

Apple ha reso pubblici quattro modelli open source che vantano una maggiore accuratezza nelle risposte alle query. Questi modelli potrebbero contribuire allo sviluppo delle future intelligenze artificiali.

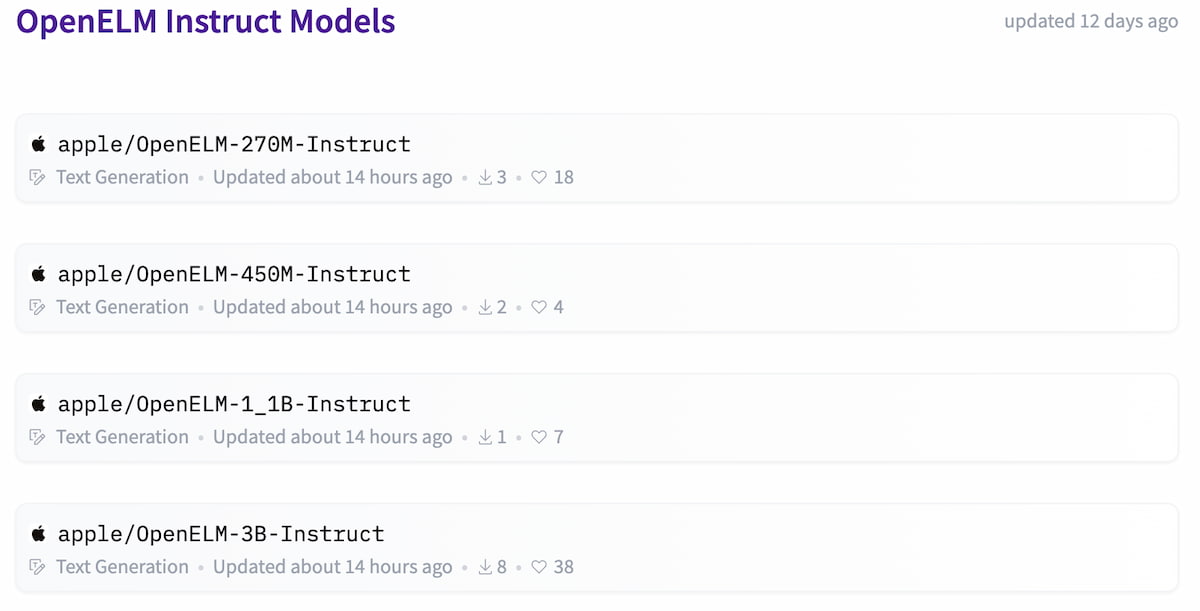

Questi modelli, denominati Efficient LLMs Open Source o OpenELMs, sono ospitati sulla piattaforma Hugging Face, utilizzata per ospitare modelli di IA, per addestrarli e per lavorare in collaborazione al loro miglioramento.

OpenELM è una libreria open source che integra diversi Large Language Models (LLMs) tramite algoritmi evolutivi. I quattro modelli OpenELM adottano una “strategia di scalabilità per strati” per distribuire i parametri all’interno dei livelli di un modello transformer, migliorando così l’accuratezza, come indicato nella Model Card rilasciata. Questi modelli sono stati preaddestrati utilizzando la libreria CoreNet. Apple ha messo a disposizione modelli sia preaddestrati che addestrati specificamente su istruzioni, utilizzando 270 milioni, 450 milioni, 1,1 miliardi e 3 miliardi di parametri.

Il set di dati utilizzato per il preaddestramento include una combinazione di un sottogruppo di Dolma v1.6, RefinedWeb, PILE deduplicato e un sottogruppo di RedPajama, risultando in un insieme di dati di circa 1,8 trilioni di token.

In un articolo pubblicato martedì, i ricercatori che hanno lavorato al progetto sostengono che la riproducibilità e la trasparenza dei Large Language Models sono essenziali per il progresso della ricerca aperta. Questo non solo garantisce l’affidabilità dei risultati ma consente anche di indagare sui pregiudizi e sui rischi associati ai modelli.

Per quanto riguarda l’accuratezza dei modelli, è stato dimostrato che, utilizzando un budget di parametri di un miliardo, OpenELM ha migliorato l’accuratezza del 2,36% rispetto a OLMo, pur richiedendo la metà dei token per il preaddestramento.

Il rilascio del codice sorgente dei modelli rappresenta l’ultimo sforzo di Apple per divulgare i suoi avanzamenti in intelligenza artificiale e machine learning. Questa non è la prima volta che Apple condivide pubblicamente le sue scoperte nel campo dell’IA. Ad ottobre, ha introdotto un LLM open source denominato Ferret, che ha perfezionato il modo in cui un modello può analizzare un’immagine. Ad aprile, una nuova versione di Ferret ha introdotto la capacità di analizzare i punti dati all’interno degli screenshot di un’app e di comprendere più in generale il funzionamento dell’app.

La WWDC di giugno sarà il momento giusto per Apple per presentare le sue ultime innovazioni nel mondo degli smartphone e dell’intelligenza artificiale.